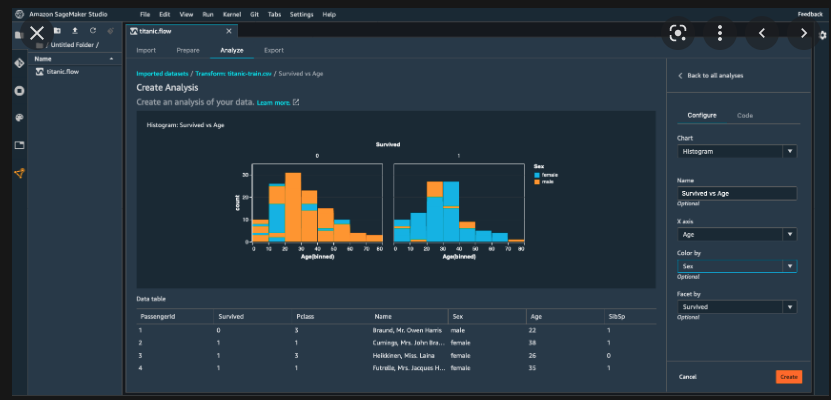

Preparación de datos y entrenamiento de modelos unificados con Amazon SageMaker Data Wrangler

[9 de junio Actualizaciones]

El 9 de junio de 2022, Amazon Web Services anunció la disponibilidad general de la partición de datos en divisiones de entrenamiento y prueba con Amazon SageMaker Data Wrangler.

La forma más rápida y sencilla de preparar los datos para el aprendizaje automático.

Amazon SageMaker Data Wrangler reduce el tiempo que se tarda en agregar y preparar los datos para el aprendizaje automático (ML) de semanas a minutos. Con SageMaker Data Wrangler, podemos simplificar el proceso de preparación de datos e ingeniería de características, y completar cada paso del flujo de trabajo de preparación de datos, incluida la selección, la limpieza, la exploración y la visualización de datos desde una única interfaz visual. Con la herramienta de selección de datos de SageMaker Data Wrangler, podemos seleccionar rápidamente datos de múltiples fuentes de datos, como Amazon S3, Amazon Athena, Amazon Redshift, AWS Lake Formation, Snowflake y Databricks Delta Lake.

Desde el 9 de junio podemos dividir los datos de nuestros clientes en conjuntos de entrenamiento y de prueba en tan solo unos clics con Data Wrangler. Anteriormente, los científicos de datos tenían que escribir código para dividir sus datos en conjuntos de entrenamiento y de prueba antes de entrenar los modelos ML. Con la nueva transformación de SageMaker Data Wrangler, podemos dividir sus datos en conjuntos de entrenamiento, prueba y validación para utilizarlos en el entrenamiento y la validación del modelo. SageMaker Data Wrangler también proporciona varios tipos de divisiones: aleatorias, ordenadas, estratificadas y basadas en claves, junto con la opción de especificar cuántos datos deben ir en cada división.

Esto nos permite mejorar el servicio que ofrecemos a las empresas y organizaciones. Porque, como han descubierto aws y nuestros técnicos, si creamos una división aleatoria de los datos en un conjunto de entrenamiento y un conjunto de prueba, podemos entrenar un modelo de aprendizaje automático en el conjunto de entrenamiento y luego evaluar su modelo de aprendizaje automático en el conjunto de prueba. Evaluar el modelo en los datos vistos durante el entrenamiento puede ser sesgado, por lo que es crucial apartar los datos de prueba antes del entrenamiento. Como resultado, la evaluación de la precisión del modelo en los datos del conjunto de prueba proporciona una estimación del rendimiento del modelo en el mundo real.

Si quieres saber más sobre las nuevas funciones, lee el blog y consulta la documentación.