Comparativa de Técnicas de Procesamiento en Tiempo Real y por Lotes: Herramientas y Aplicaciones

El procesamiento de datos es un elemento clave en la era de la información, donde rapidez y precisión son fundamentales para la toma de decisiones. Dos enfoques ampliamente utilizados son el procesamiento en tiempo real y por lotes. El procesamiento en tiempo real implica el análisis y respuesta a datos de forma inmediata, mientras que el procesamiento por lotes se refiere al procesamiento de datos en grupos o conjuntos.

Cada enfoque tiene sus ventajas y aplicaciones específicas.

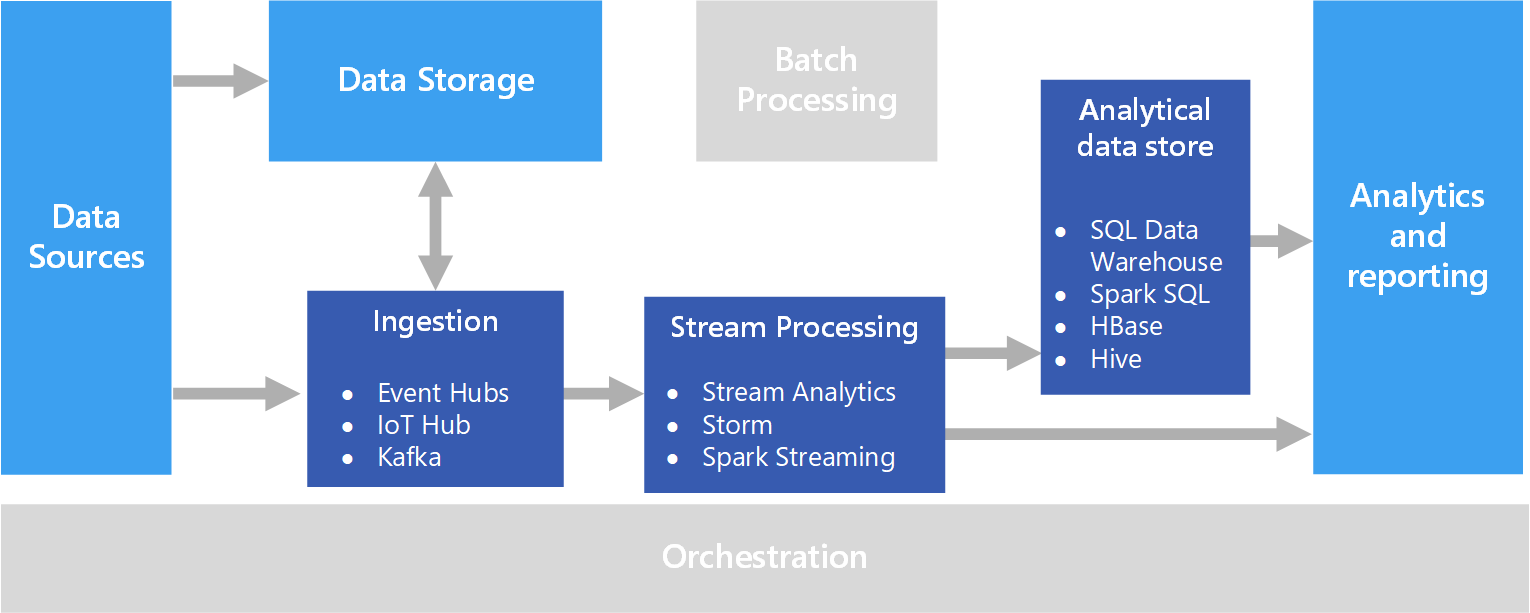

Real-time pipeline

Procesamiento en Tiempo Real

El procesamiento en tiempo real implica el análisis y respuesta a los datos a medida que llegan, sin demora perceptible. Para lograr esto, se utilizan herramientas especializadas como:

Apache Kafka

Es una plataforma de streaming distribuido que permite la transmisión y procesamiento de datos en tiempo real. Utiliza un modelo de publicación-suscripción para el flujo de datos y es altamente escalable y duradero.

Apache Storm

Un sistema de procesamiento en tiempo real distribuido, diseñado para el procesamiento de flujos de datos a alta velocidad. Utiliza topologías para definir el procesamiento de datos y garantiza una baja latencia.

Spark Streaming

Es una extensión de Apache Spark que permite el procesamiento de datos en tiempo real utilizando micro lotes (pequeños fragmentos de datos). Ofrece alta escalabilidad y tolerancia a fallos.

Aplicaciones

- Monitoreo de redes y sistemas.

- Análisis de redes sociales en tiempo real.

- Detección de fraudes en transacciones financieras.

Procesamiento por Lotes

El procesamiento por lotes implica la recopilación y procesamiento de datos en grupos o conjuntos en lugar de forma continua y en tiempo real. Herramientas comunes para este enfoque son:

Apache Hadoop

Un marco de trabajo que permite el procesamiento distribuido de grandes conjuntos de datos en clústeres de computadoras. Utiliza el sistema de archivos distribuido HDFS y el modelo de programación MapReduce.

Apache Spark

Una plataforma de análisis de datos en memoria que permite el procesamiento de grandes conjuntos de datos en paralelo. Ofrece mejoras significativas en velocidad en comparación con MapReduce.

Apache Flink

Un sistema de procesamiento distribuido y tolerante a fallos que puede manejar tanto el procesamiento en tiempo real como por lotes. Ofrece baja latencia y alto rendimiento.

Aplicaciones

- Análisis histórico de datos.

- Generación de informes y análisis de tendencias.

- Procesamiento de grandes volúmenes de datos para inteligencia empresarial.

Ambos enfoques, procesamiento en tiempo real y por lotes, son cruciales en el mundo actual de la analítica de datos. La elección entre ellos depende de las necesidades específicas de la aplicación y las limitaciones de tiempo, latencia y recursos. Herramientas como Apache Kafka, Apache Storm, Apache Spark y Apache Flink ofrecen soluciones robustas para implementar estos enfoques y abordar una amplia gama de aplicaciones en la era moderna de procesamiento de datos.